AI 生产力的未来会是什么样子?全世界都在等待微软的答案。

5 月 22 日凌晨,微软 Build 2024 开发者大会在美国西雅图召开,今天的发布有关 AI 技术,更有关 AI 带来的新工具。

「三十多年来,微软对于计算机一直有两个梦想 —— 首先是让计算机理解我们,而不是我们去理解计算机;其次,在信息不断增加的世界中,让计算机帮助我们根据信息有效地进行推理、计划和行动。人工智能浪潮已经为我们的梦想找到了答案,」微软 CEO 萨蒂亚・纳德拉说道。

今天 Build 大会的内容主要最新的 Copilot,适用于生成式 AI 的新形态硬件,以及使用新 AI 能力的工具堆栈。

当然,除了大量应用整合、与 AI 创业公司、硬件厂商的合作,还有微软自研的全新 AI 大模型。

Copilot+PC,有专用端侧模型

原生支持 PyTorch

首先是有关 PC 新形态 Copilot+PC 的内容。微软表示,将于 618 上市的首批机型会搭载高通 Snapdragon X 系列处理器,在今年晚些时候将推出更多基于英特尔和 AMD 处理器的此类设备。

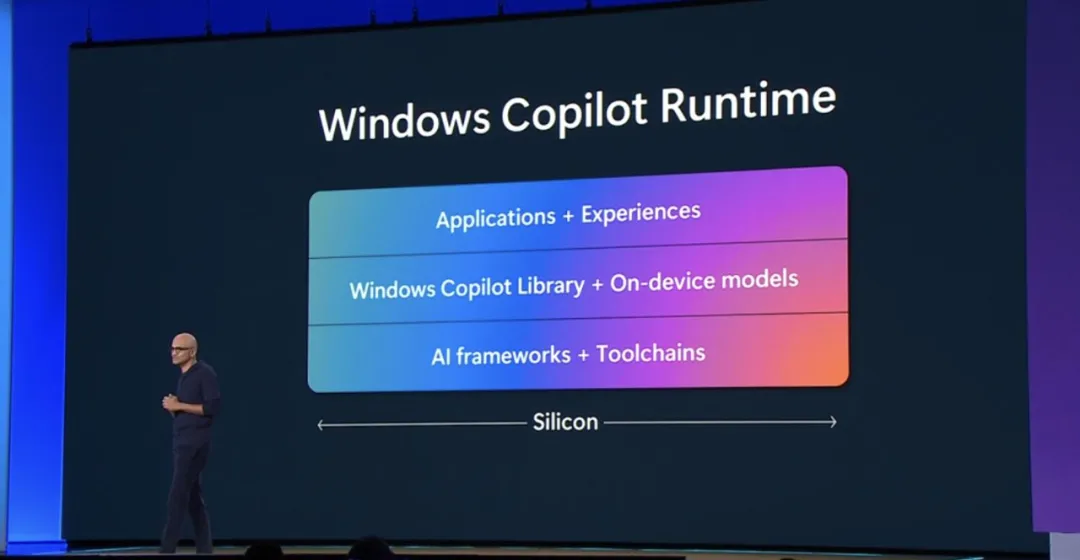

目前已推出的版本因为 NPU 拥有 40+ TOPS 的 AI 算力,运行 AI 工作负载的能力增强了 20 倍,效率提高了 100 倍。这样的硬件基础,让 AI PC 绝不是接入云端的 GPT-4o 那么简单,Windows 现在从三个层面提供 AI 体验。

Windows Copilot 堆栈现在通过 Windows Copilot Runtime 扩展到了 Windows 上,人工智能对系统进行了自内而外的改造,使开发人员能够加速 Windows 上的人工智能开发。

纳德拉表示,Windows Copilot Runtime 包含一组 API,由 Windows 附带的 40 多个端侧 AI 模型提供支持,包括一种名为 Phi-Silica 的小语言模型(SLM),专为 Copilot+ PC 中的 NPU 设计。他们会被用于智能搜索、实时翻译、图像生成和处理等任务。

微软表示,Phi-Silica 完全使用 NPU 进行推理,首个 token 输出速度为 650 token/s,仅消耗约 1.5 瓦的电量,可以让 CPU 和 GPU 同时用于其他计算任务。持续运行时,文本生成重用 NPU 中的 KV 缓存并在 CPU 上运行,每秒生成约 27 个 token。

微软提出了 Windows 语义索引,这是一种新的操作系统功能,重新定义了 Windows 上的搜索并支持 Recall 等新体验。稍后,微软将向使用 Vector Embeddings API 的开发人员提供此功能,以便人们在应用程序中基于数据构建自己的矢量存储和 RAG。

新的 Copilot+PC 还自带原生的人工智能框架和工具链,方便开发人员将自己的端侧模型引入 Windows。微软正式宣布通过 DirectML,PyTorch 和 Web 神经网络现在将在 Windows 上本地运行。这将为开发人员提供更多可用的工具,允许数千个 Hugging Face 模型在 Windows 上运行。NPU 也可以帮助这些工具比以往更快的速度完成任务。

就像 DirectX 之于图形处理一样,DirectML 是 Windows 中用于机器学习的高性能低级 API。DirectML 对微软的独立硬件供应商 (IHV)合作伙伴为 Windows 生态系统提供的不同硬件进行抽象,并支持 GPU 和 NPU,CPU 集成也即将推出。它集成了 AI 领域的相关框架,例如 ONNX Runtime、PyTorch 和 WebNN。

此外,Windows Subsystem for Linux(WSL)可以同时运行 Windows 和 Linux 工作负载,为 Windows 上的 AI 开发提供平台。开发人员可以在不同环境之间轻松共享文件、GUI 应用程序、GPU 等,无需额外的设置。

昨天,微软向世界介绍了全新的 Windows 11 AI PC,再加上今天在 Build 开发者大会上宣布的强大功能,Windows 正在成为极具开放性的 AI 平台和开发者平台。

这些进化,似乎会把开发者们瞬间从 Mac 上吸引过来。

Copilot 持续升级

开始卷团队协作

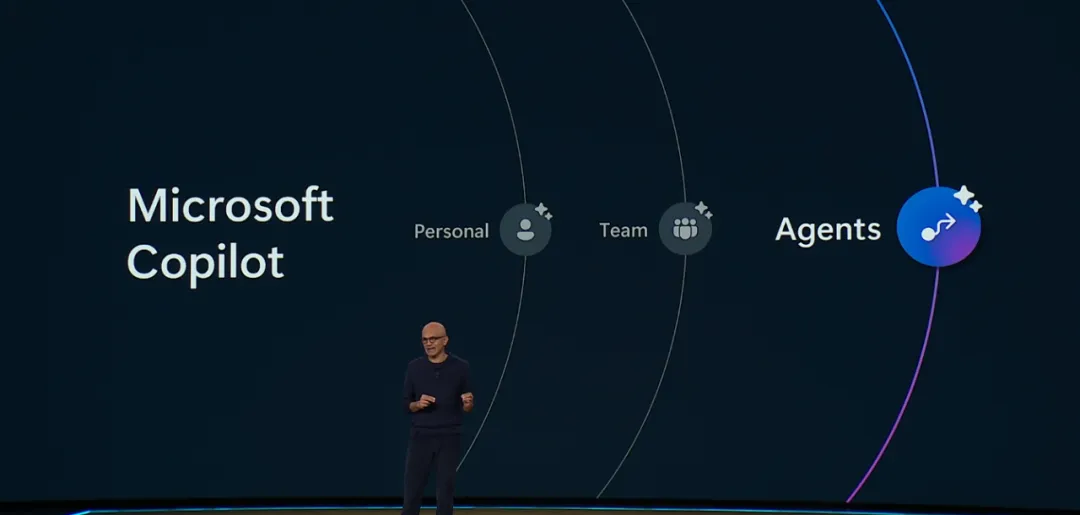

接下来是一系列面向个人和团队的 AI 生产力提升。

围绕 AI 软件开发能力,GitHub 推出首套由微软和第三方合作伙伴开发的 GitHub Copilot 扩展,现已开启受邀预览。新增功能允许开发者、企业通过其偏好的服务(如 Azure、Docker、Sentry 等)直接在 GitHub Copilot 智能副驾驶 Chat 中定制其 GitHub Copilot 智能副驾驶体验。

作为微软推出的扩展功能之一,GitHub Copilot 智能副驾驶 for Azure 展示了如何利用自然语言和更广泛的功能来提高开发速度。通过 Copilot 智能副驾驶 Chat 使用该扩展,开发者可以探索和管理 Azure 资源,同时排除故障、查找相关日志和代码。

在本次大会上,微软展示了 Copilot 如何提升组织的团队协作和业务效率。纳德拉主要介绍了以下三个升级:

- Team Copilot 将 Copilot 扩展到个人助理之外,为团队工作,改善协作和项目管理。

- Agents:自定义 Copilot 使客户能够协调和自动化业务流程。

- Copilot 扩展(extensions)和 Copilot 连接器(connectors)使定制和扩展 Copilot 变得更加容易,以满足特殊的业务需求。

Team Copilot

Team Copilot 使 Copilot 不再只是个人助理,而成为有价值的团队成员,与其他成员一起参与并做出贡献。当然,你全程掌控,将任务或职责分配给 Copilot,使得整个团队共同提高效率、协作和创造力。

Team Copilot 可以在 Microsoft Teams、Microsoft Loop、Microsoft Planner 等协作应用中使用。

具体而言,Team Copilot 可以扮演以下三种角色。

一是会议主持人。Copilot 通过管理议程和记录会议中共同撰写的笔记,使会议中的讨论更加富有成效。

小组协作者:Copilot 帮助每个人从聊天中获得更多收获,展示最重要的信息,跟踪行动项目,并解决未解决的问题。

项目经理:Copilot 通过创建和分配任务、跟踪截止日期以及在需要团队成员输入时通知他们,确保每个项目顺利进行。

这些功能将于 2024 年晚些时候,在预览版中提供给拥有 Microsoft Copilot for Microsoft 365 许可证的客户。

Agents

Agents 是可以实现业务流程自动化的全新自定义 Copilot。每个业务流程都有待提高效率和释放新价值,并且每个流程都各不相同。

因此,微软宣布 Microsoft Copilot Studio 推出新功能,可以构建自定义 Copilot,作为 Agents 在客户的指导下独立工作。Agents 的功能包括如下:

- 实现长期运行的业务流程自动化

- 推理操作和用户输入

- 利用内存引入上下文

- 根据用户反馈进行学习

- 记录异常请求并寻求帮助

如下为创建自定义 Copilot(即 Agents)的演示。

这些 Agents 功能可供抢先体验计划(Early Access Program)中的客户使用。

此外,微软通过 Copilot 扩展和 Copilot 连接器进一步丰富了 Copilot 的功能。

借助新的 Copilot 扩展,任何人都可以轻松地自定义 Copilot 操作并将 Copilot 扩展到他们的数据和业务线系统。开发人员可以使用 Copilot Studio 或 Teams Toolkit for Visual Studio 构建这些扩展。

微软还在 Copilot Studio 中引入了 Copilot 连接器,让开发人员可以更轻松、更快速地创建 Copilot 扩展。

这一系列能力,可以让开发者们更方便地把人工智能纳入到自己的产品和服务体系中。

小模型 Phi-3 家族上新

多模态 Phi-3-Vision 亮相

作为 OpenAI 最新发布的旗舰模型,GPT-4o 现可在 Azure AI Studio 中使用,也可作为 API 使用。这一开创性的多模态模型集成了文本、图像和音频处理,为生成式和对话式 AI 体验设定了新标准。

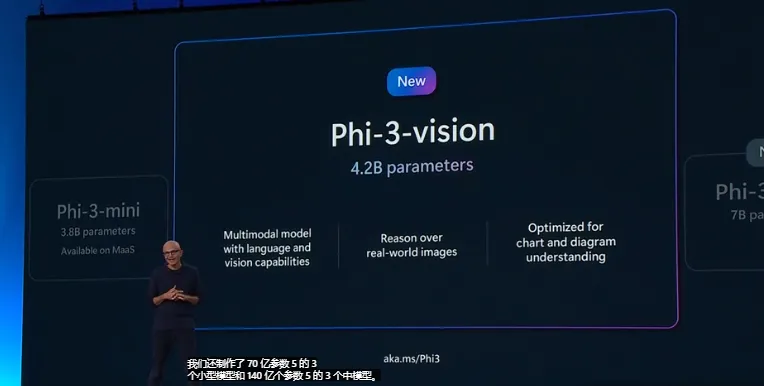

微软开发的 AI 小语言模型(SLMs)Phi-3 系列也发布了一款新的多模态模型 ——Phi-3-vision,并已可在 Azure 中使用。

开发者可在 Azure AI Playground 中体验这些最先进的前沿模型,并能在 Azure AI Studio 中开始构建和定制模型。

作为以创新智能手机和智能设备享誉全球的全球科技品牌,OPPO 正在将 Azure AI 语音转文本(speech-to-text)、快速转录(Fast Transcription)和 Azure AI 文本转语音(text-to-speech)技术在其新款智能手机上试点,以期为客户带来全新体验。

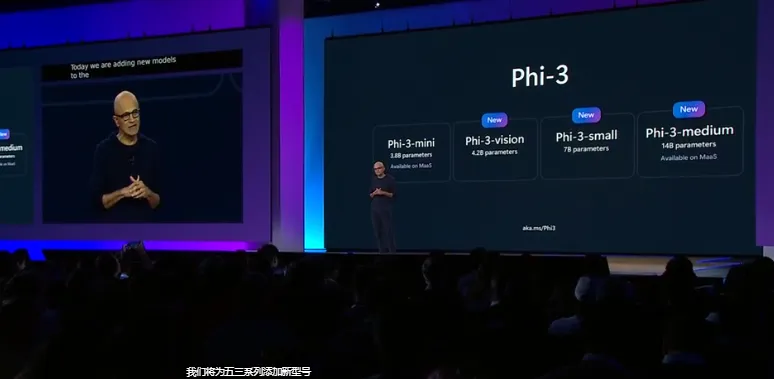

Phi-3 模型家族现有四个模型,每个模型都根据微软负责任的 AI、安全标准进行指令调整和开发,以确保可以直接使用。

- Phi-3-vision 是一个具有语言和视觉功能的 4.2B 参数多模态模型,支持 128K 上下文长度。

- Phi-3-mini 是一个具有 3.8B 参数的语言模型,支持 128K 和 4K 两种上下文长度。

- Phi-3-small 是一个具有 7B 参数的语言模型,支持 128K 和 8K 两种上下文长度。

- Phi-3-medium 是一个具有 14B 参数的语言模型,支持 128K 和 4K 两种上下文长度。

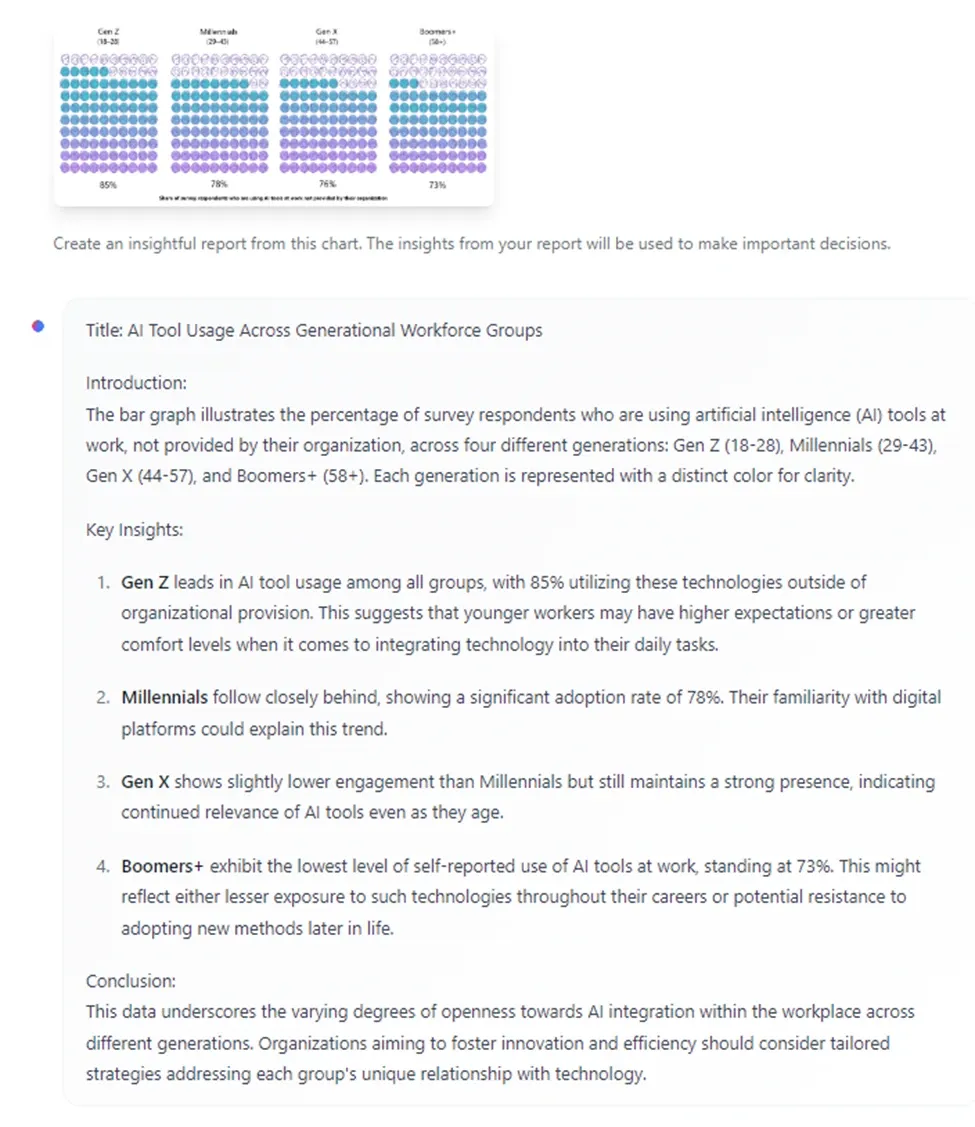

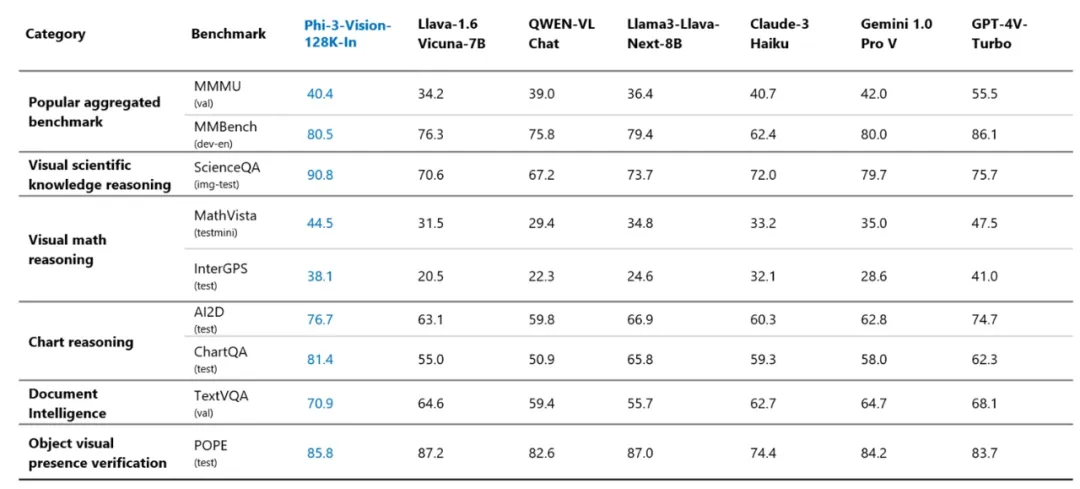

其中,Phi-3-vision 是 Phi-3 家族中的第一个多模态模型,它将文本和图像结合在一起,并能够推理现实世界的图像以及从图像中提取和推理文本。该模型还针对图表理解进行了优化,可用于生成见解和回答问题。

Phi-3-vision 以 Phi-3-mini 的语言功能为基础,继续在小模型中整合强大的语言和图像推理质量。如下图所示,Phi-3-vision 可以从图表和图解中生成见解。

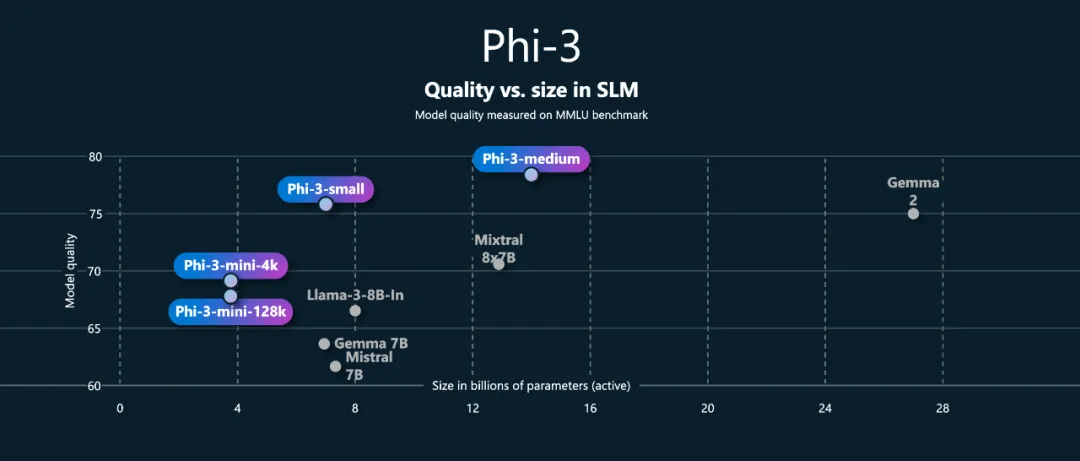

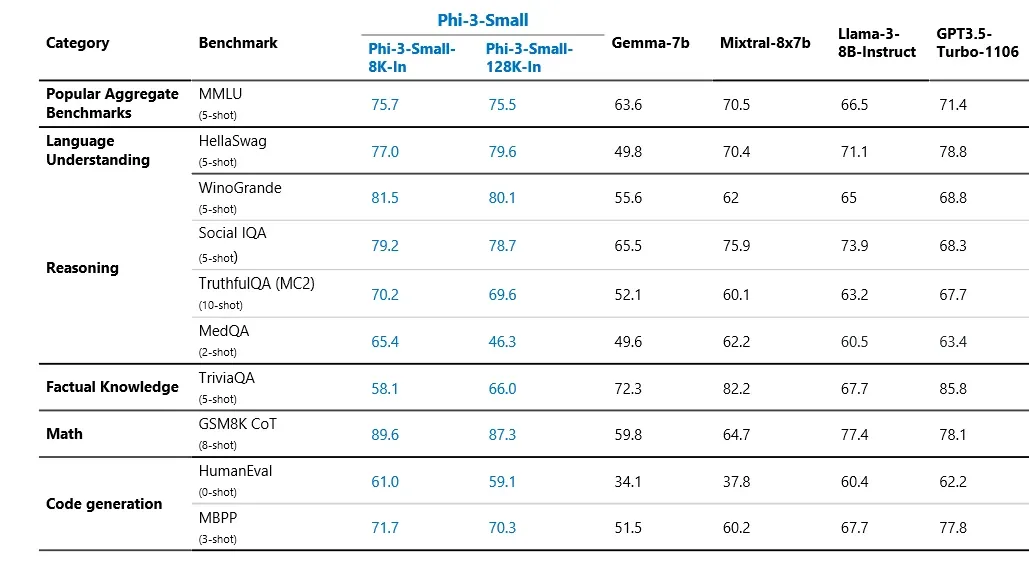

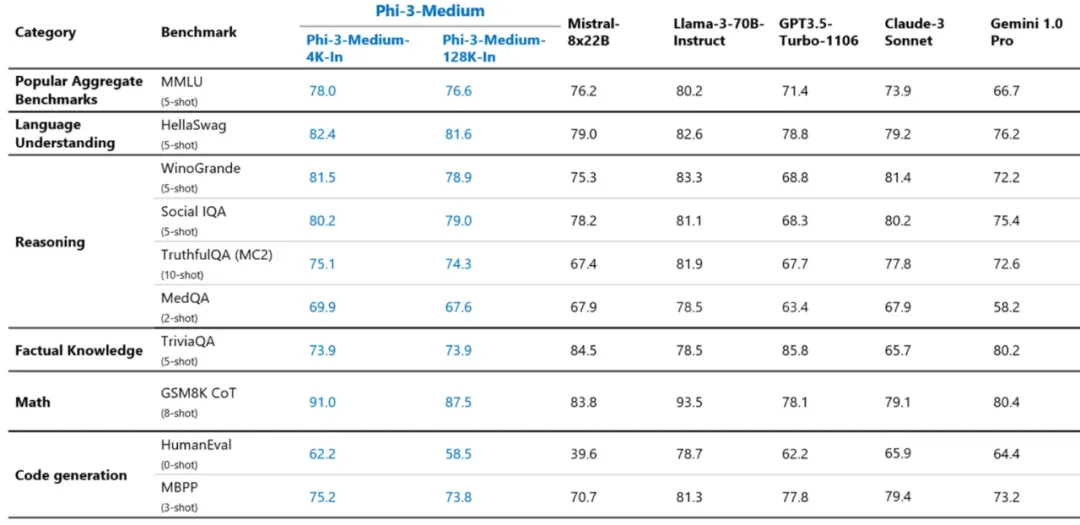

Phi-3-small 和 Phi-3-medium 的表现优于同等规模以及规模更大的语言模型。

7B 参数的 Phi-3-small 在各种语言、推理、编码和数学基准测试中击败了 GPT-3.5 Turbo。

14B 参数的 Phi-3-medium 延续了这一趋势,并且表现优于 Gemini 1.0 Pro。

4.2B 参数的 Phi-3-vision 在一般视觉推理任务、OCR、表格和图表理解任务中,表现优于 Claude-3 Haiku 和 Gemini 1.0 Pro V 等更大的模型。

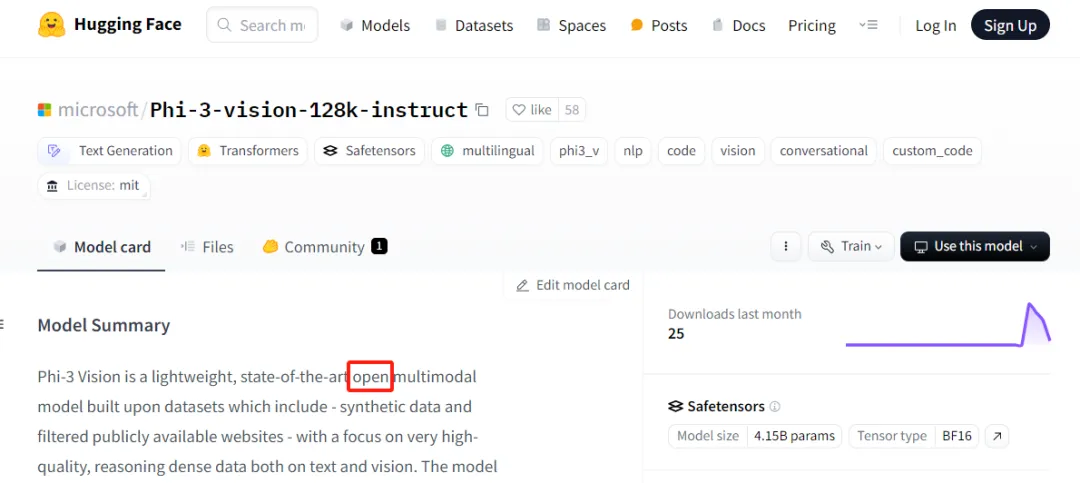

当然,Phi-3-vision 模型是开源的。

Hugging Face 地址:https://huggingface.co/microsoft/Phi-3-vision-128k-instruct

这一模型的发布令研究者们兴奋不已,有人已经开始畅想其在机器人领域的应用了。

从 Phi-3 到 Phi-Silica,我们可以看到微软对大模型的探索聚焦于应用,与自己支持的 OpenAI 区分了生态位。

最强气氛组 ——OpenAI CEO 奥特曼

在微软官宣了一系列更新后,OpenAI CEO 奥特曼也来到了活动现场以示支持。他鼓励开发者和初创公司利用当前的人工智能热潮,认为这是自移动设备繁荣甚至互联网出现以来最令人兴奋的时刻。

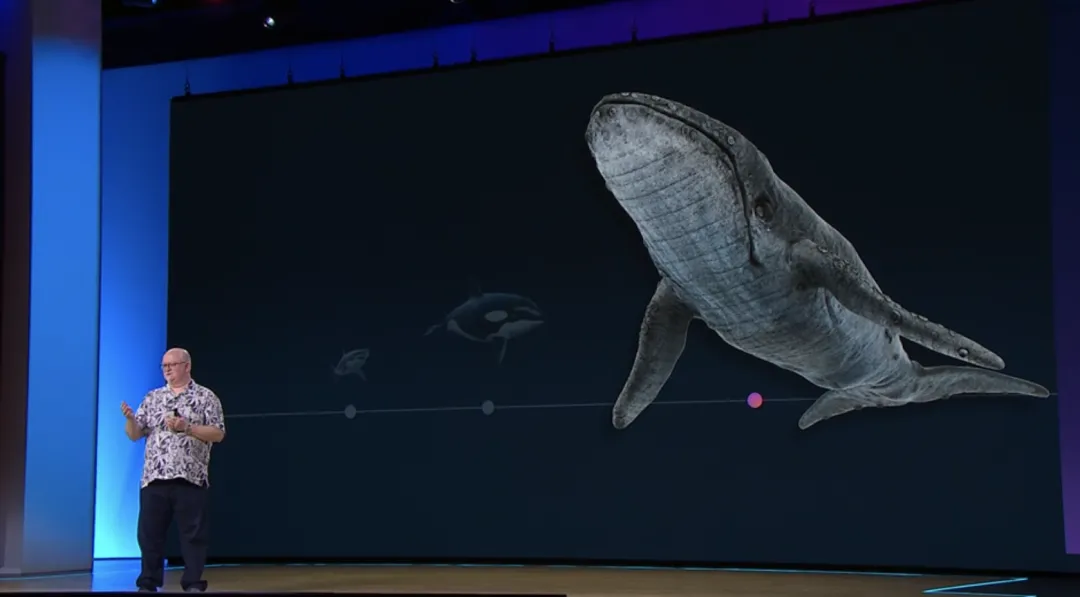

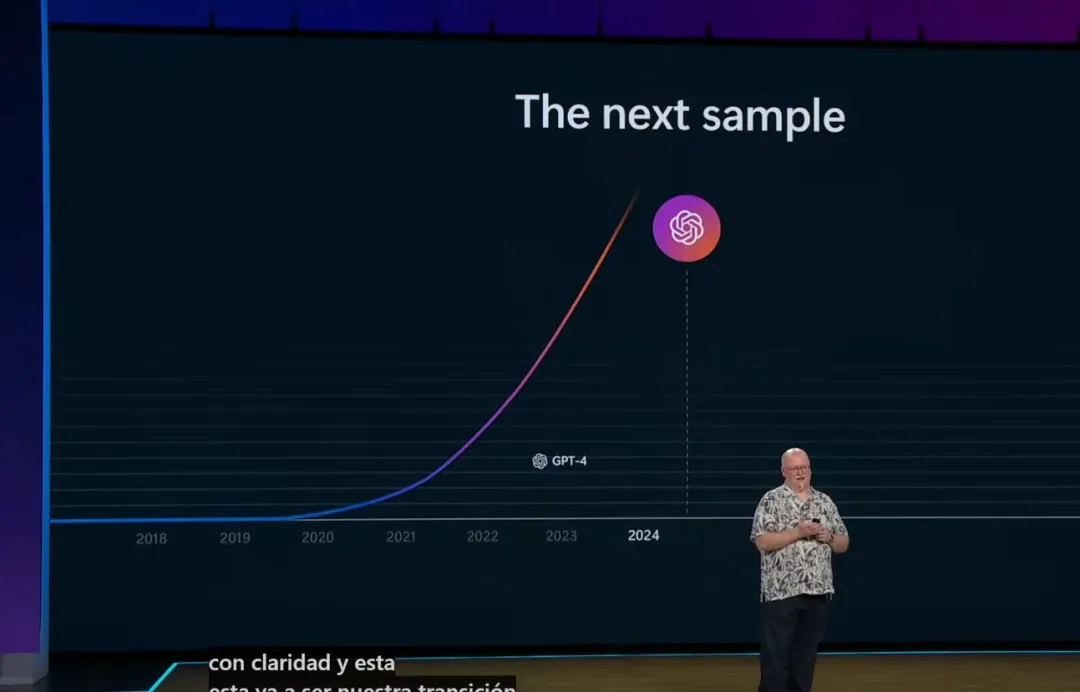

在模型方面,奥特曼透露,未来,GPT-4o 将变得更快,但更便宜。他还很高兴地预告,下一个大模型即将问世。微软为这项工作建造了一台更大的超级计算机(如同虎鲸一样规模的超算)。

奥特曼暗示,新的模态和整体智能将是 OpenAI 下一个模型的关键。「最重要的一点,听起来也是我能说的最无聊的一点...... 模型会变得越来越智能,总的来说是全面智能。」

不过,他也指出,新技术并不能让开发人员摆脱艰苦的工作。这项工作还有待完成。开发者必须弄清楚如何让这些技术对人们有用。他说,最好不要忘记,将这些新技术带入生活并不容易。