译者 | 李睿

审校 | 重楼

在当今快节奏的技术和市场环境中,高效地部署人工智能(AI)/机器学习(ML)应用程序至关重要。Kubernetes是一个强大的开源平台,已经成为管理和扩展容器化应用程序的领先解决方案,确保它们在各种环境中无缝运行。

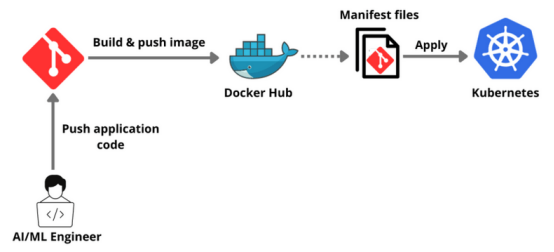

在本指南中,将引导开发人员逐步完成在Kubernetes上部署任何AI/ML应用程序的过程。从容器化应用程序到设置Kubernetes集群,再到部署AI/ML应用程序,涵盖了所有内容。

为什么在Kubernetes上部署生成式人工智能应用程序?

在Kubernetes上部署AI/ML应用程序为管理复杂的AI/ML工作负载提供了一个强大的解决方案。其主要优点之一是可扩展性。Kubernetes可以自动扩展基础设施,有效地适应不同的工作负载,并确保根据需求有效地分配资源。这种自动扩展功能对于处理AI/ML任务中涉及的大型计算至关重要。

此外,Kubernetes支持多云和混合云环境,提供灵活性并避免供应商锁定。它为开发、测试和部署提供了一致和统一的运行环境,增强了数据科学家和工程师之间的协作。

Kubernetes还确保了高可用性和容错性,自动替换或重新调度失败的容器,确保了AI/ML应用程序的可靠性和健壮性。此外,它简化了许多操作,包括更新和回滚,允许团队更多地专注于构建AI/ML模型,而不是管理基础设施。

先决条件

- Docker Desktop安装容器化应用程序。

- 在安装Minikube之后,将使用Minikube创建一个单节点集群。

- 下载并安装Node.js,因为示例应用程序是Node.js应用程序。

- 注册一个免费的SingleStore数据库云帐户,将应用程序与数据库集成。

教程

首先,注册一个GitHub账户。

然后,将已经可用的openai-quickstart-node存储库克隆到本地。

分享说明:转发分享请注明出处。