译者 | 李睿

审校 | 重楼

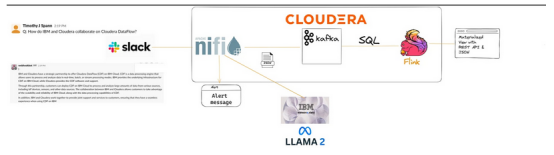

本文将展示如何使用由Apache NiFi支持的Cloudera DataFlow与IBM WatsonX交互。人工智能实时建立大型语言模型,并且可以使用任何基础模型,例如谷歌FLAN T5 XXL或IBM Granite模型。

本文将展示构建实时数据管道是多么容易,它可以直接向开发人员的Slack和移动应用程序提供问题,以确保WatsonX的安全。在IBM云平台中运行的人工智能模型。开发人员可以使用Cloudera DataFlow处理所有的安全性、管理、沿袭和治理。作为决策的一部分,可以选择不同的WatsonX。人工智能根据提示的类型进行动态建模。例如,如果想编写内容,而不是回答一个问题,可以选择不同的模型。回答谷歌FLAN T5 XXL的问题效果很好。如果想继续编写内容,可以使用一个IBM Granite模型。

人们会注意到WatsonX的速度有多快。人工智能模型返回开发人员需要的结果。这里进行了一些快速的转换和丰富内容,然后将它们发送到Cloudera Apache Kafka,用于持续分析和分发到许多其他应用程序、系统、平台和下游消费者。此外,还将向原始请求者输出答案,这可能是Slack频道中的某一个或应用程序中的某一个。所有这些都是实时发生的,没有代码,没有完整的治理、沿袭、数据管理和任何规模、任何平台上的安全性。

IBM和Cloudera在私有云、公共云和混合云环境中对实时数据和人工智能的共同作用才刚刚开始。

逐步实时流程

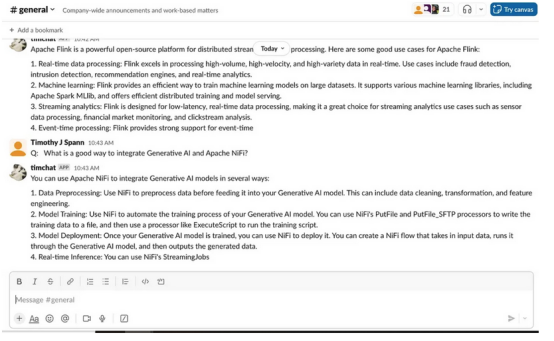

首先,在Slack中输入一个问题:“整合生成式AI和Apache NiFi的一个好方法是什么?”

NiFi Flow Top

NiFi Flow Top

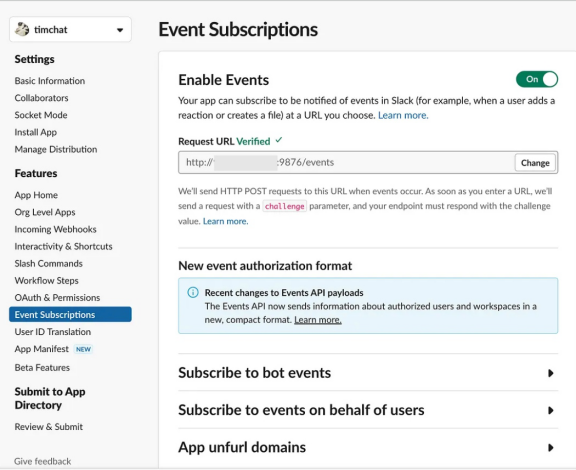

一旦输入这个问题,Slack服务器将这些事件发送到注册的服务。它可以在任何面向公众的地方托管。

- (点击https://api.slack.com/查看Slack API链接)

Slack API

Slack API

一旦启用,服务器将开始接收每个Slack帖子的JSON事件。这在NiFi中很容易接收和解析。Cloudera DataFlow允许在公共云托管版本中轻松接收安全的HTTPS REST调用,即使在Designer模式下也是如此。

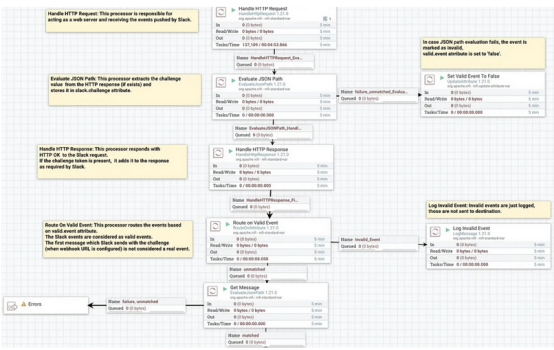

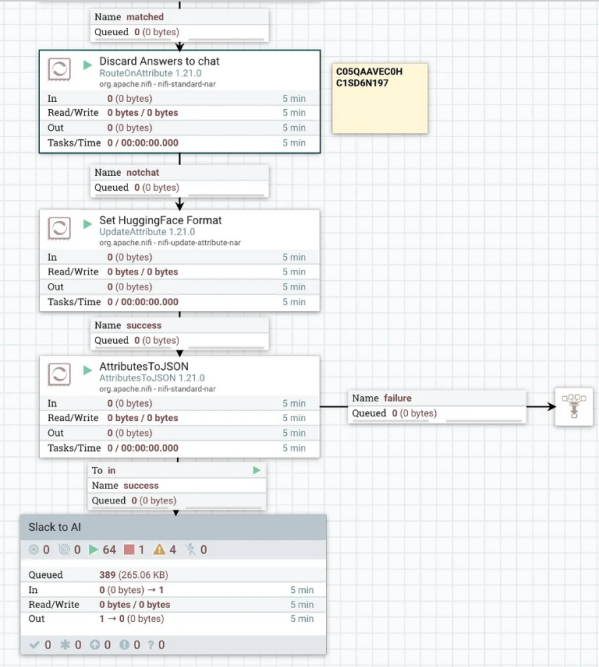

NiFi Top Flow 2

NiFi Top Flow 2

在NiFi Top Flow的第一部分中,接收到REST JSON Post,如下所示:

Slackbot 1.0 (+https://api.slack.com/robots)

application/json

POST

HTTP/1.1

{

"token" : "qHvJe59yetAp1bao6wmQzH0C",

"team_id" : "T1SD6MZMF",

"context_team_id" : "T1SD6MZMF",

"context_enterprise_id" : null,

"api_app_id" : "A04U64MN9HS",

"event" : {

"type" : "message",

"subtype" : "bot_message",

"text" : "==== NiFi to IBM <http://WatsonX.AI|WatsonX.AI> LLM Answers\n\nOn Date: Wed, 15 Nov 20分享说明:转发分享请注明出处。