Sora 问世才不到两个星期,谷歌的世界模型也来了,能力看起来更强大:它生成的虚拟世界「自主可控」。

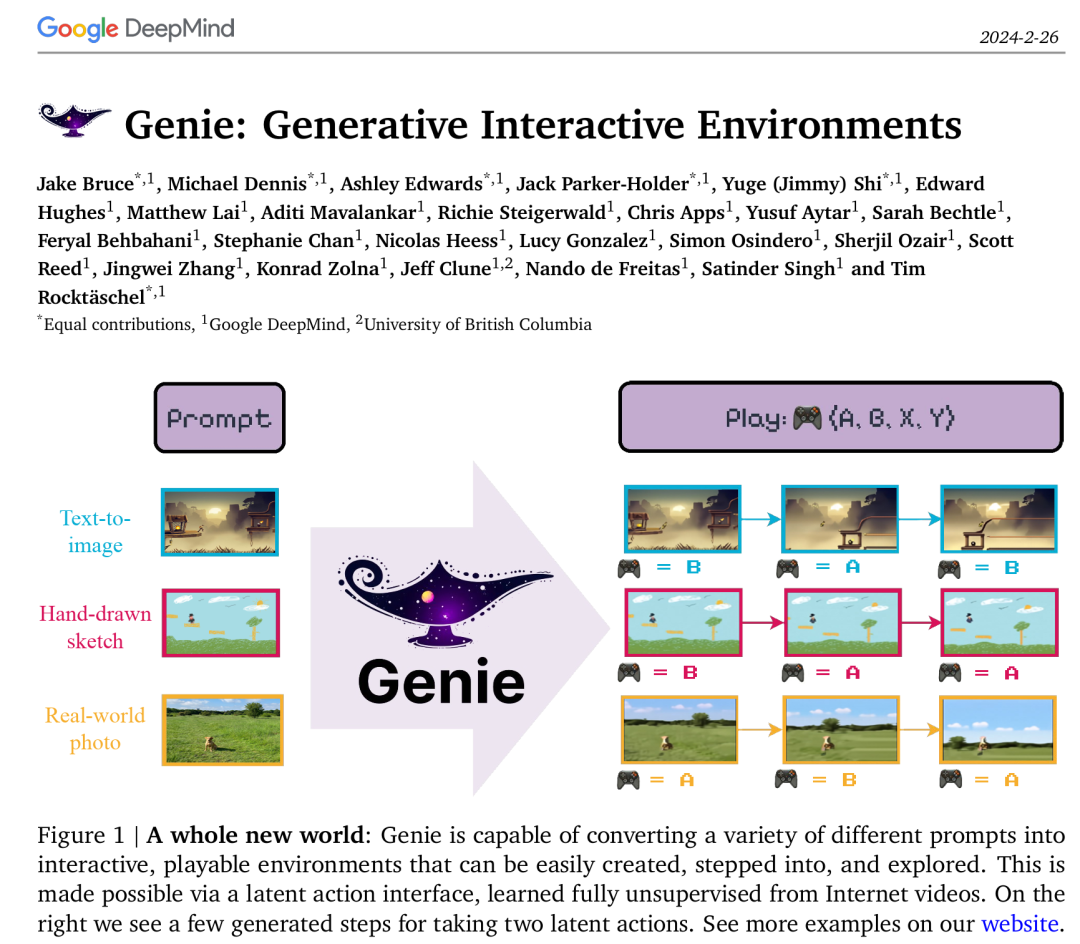

刚刚,谷歌定义了生成式 AI 的全新范式 —— 生成式交互环境(Genie,Generative Interactive Environments)。Genie 是一个 110 亿参数的基础世界模型,可以通过单张图像提示生成可玩的交互式环境。

我们可以用它从未见过的图像进行提示,然后与自己想象中的虚拟世界进行互动。

不管是合成图像、照片甚至手绘草图,Genie 都可以从中生成无穷无尽的可玩世界。

Genie 由三个部分组成:一个潜在动作模型,用于推断每对帧之间的潜在动作;一个视频 tokenizer,用于将原始视频帧转换为离散 token;一个动态模型,用于在给定潜在动作和过去帧 token 的情况下,预测视频的下一帧。

看到这项技术发布,很多人表示:谷歌又要来领导 AI 技术了。

谷歌还提出,Genie 学到的潜在动作可以转移到真实的人类设计的环境中。在这个假设基础上,谷歌针对机器人视频训练了一个 Genie 模型,作为机器人领域潜在世界模型应用的概念验证。

被颠覆的游戏、设计、XR、机器人行业……

我们可以从四个维度来理解 Genie 的革命性意义。

首先,Genie 可以在没有动作标签时学习控制。

具体来说,Genie 借助大量公开的互联网视频数据集进行了训练,没有任何动作标签数据。

这本来是一个挑战,因为互联网视频通常没有关于正在执行哪个动作、应该控制图像哪一部分的标签,但 Genie 能够专门从互联网视频中学习细粒度的控制。

对于 Genie 而言,它不仅了解观察到的哪些部分通常是可控的,而且还能推断出在生成环境中一致的各种潜在动作。需要注意的是,相同的潜在动作如何在不同的 prompt 图像中产生相似的行为。

其次,Genie 可以培养下一代「创作者」(creator)。

只需要一张图像就可以创建一个全新的交互环境,这为生成和进入虚拟世界的各种新方法打开了大门。例如,我们可以使用最先进的文本生成图像模型来生成起始帧,然后与 Genie 一起生成动态交互环境。

在如下动图中,谷歌使用 Imagen2 生成了图像,再使用 Genie 将它们变为现实:

Genie 能做到的不止如此,它还可以应用到草图等人类设计相关的创作领域。

或者,应用在真实世界的图像中:

再次,谷歌认为 Genie 是实现通用智能体的基石之作。以往的研究表明,游戏环境可以成为开发 AI 智能体的有效测试平台,但常常受到可用游戏数量的限制。

现在借助 Genie,未来的 AI 智能体可以在新生成世界的无休止的 curriculum 中接受训练。谷歌提出一个概念证明,即 Genie 学到的潜在动作可以转移到真实的人类设计的环境中。

最后,谷歌表示,Genie 是一种通用方法,可以应用于多个领域,而不需要任何额外的领域知识。

尽管所用数据更多是 2D Platformer 游戏游戏和机器人视频,但该方法具备通用性,适用于任何类型的领域,并可扩展到更大的互联网数据集。

谷歌在 RT1 的无动作视频上训练了一个较小的 2.5B 模型。与 Platformers 的情况一样,具有相同潜在动作序列的轨迹通常会表现出相似的行为。

这表明 Genie 能够学习一致的动作空间,这可能适合训练机器人,打造通用化的具身智能。

技术揭秘:论文《Genie: Generative Interactive Environments》已公布

谷歌 DeepMind 已经放出了 Genie 论文。

论文的共同一作多达 6 人,其中包括华人学者石宇歌(Yuge (Jimmy) Shi)。她目前是谷歌 DeepMind 研究科学家, 2023 年获得牛津大学机器学习博士学位。

方法介绍

Genie 架构中的多个组件基于 Vision Transformer (ViT) 构建而成。值得注意的是,由于 Transformer 的二次内存成本给视频领域带来了挑战,视频最多可以包含